AI: Claude Code optimierte Prompts

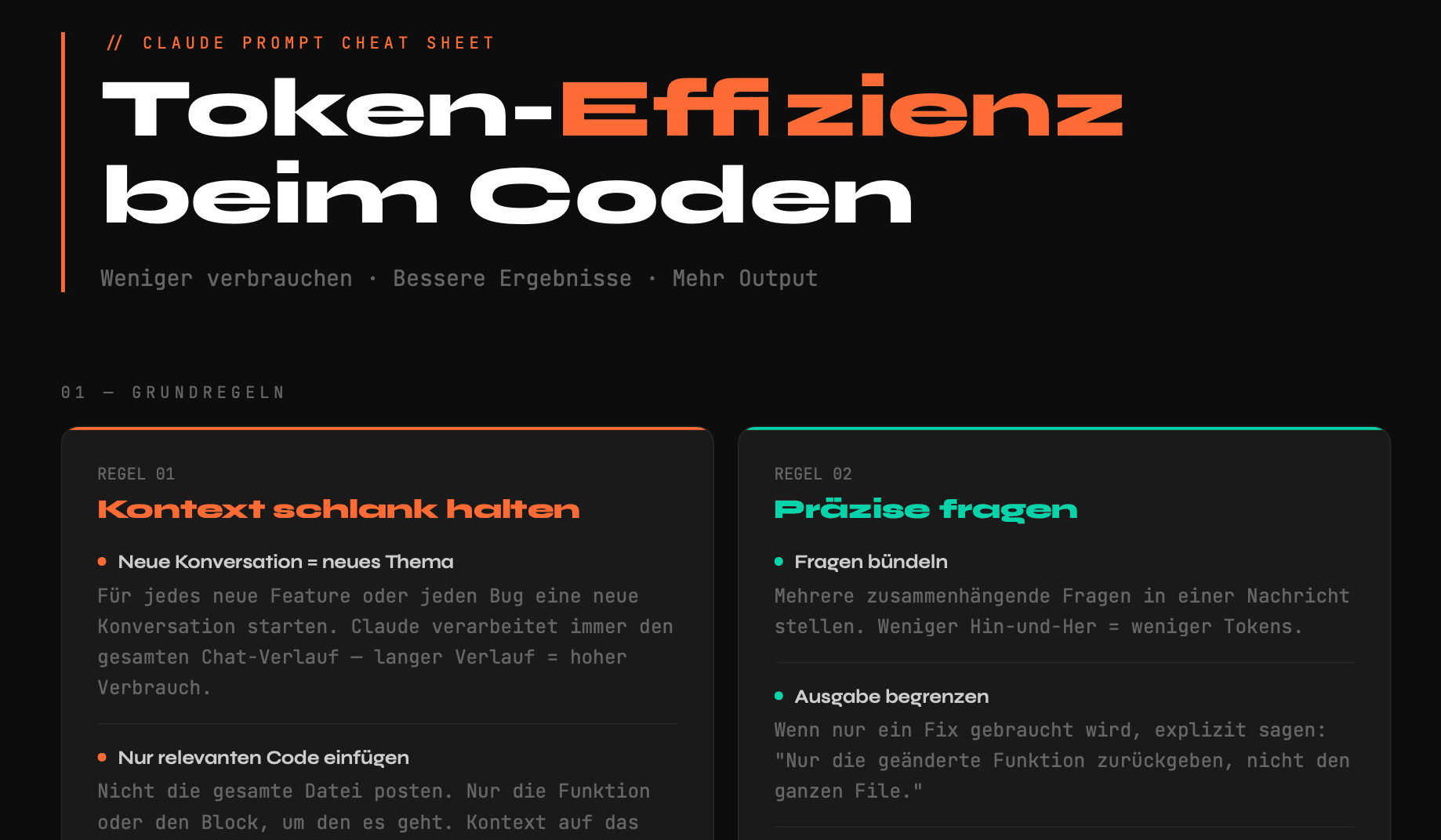

Token-Effizienz beim Coden

Mein Claude Prompt Cheat Sheet als PDF

Wer regelmäßig mit LLMs wie Claude arbeitet, merkt schnell:

Nicht das Modell ist der Engpass – sondern der Kontext.

Zu viel Verlauf.

Zu viel irrelevanter Code.

Zu offene Fragen.

Und plötzlich sind die Tokens weg.

Genau deshalb habe ich mir ein kompaktes Prompt Cheat Sheet für effizientes Coden gebaut – optimiert auf:

- weniger Tokenverbrauch

- präzisere Antworten

- weniger Hin-und-Her

- reproduzierbare Ergebnisse

Das Ganze gibt es jetzt als druckbares PDF.

Warum Token-Effizienz wichtig ist

LLMs verarbeiten immer den kompletten Chat-Verlauf. Das bedeutet:

- Je länger die Konversation, desto höher der Verbrauch

- Je mehr irrelevanter Code, desto größer der Kontext

- Je offener die Frage, desto länger die Antwort

Effizientes Prompting ist deshalb kein „Nice to have“, sondern ein echter Produktivitätsfaktor – besonders beim Coden.

Was im Cheat Sheet drin ist

Das Sheet ist in drei Bereiche gegliedert:

1. Grundregeln

Klare Prinzipien wie:

- Neue Konversation = neues Thema

- Nur relevanten Code posten

- Dateien nicht mehrfach hochladen

- Ausgabe explizit begrenzen

- Modell bewusst wählen (Sonnet vs. Opus)

Ziel: Kontext klein halten und trotzdem maximale Qualität bekommen.

2. Template Prompts

Fertige Copy-Paste Vorlagen für typische Dev-Tasks:

- Bugfix

- Neues Feature

- Refactoring

- Code Review

- Tests schreiben

- Architektur-Entscheidungen

Alle Templates sind so formuliert, dass:

- keine unnötigen Einleitungen generiert werden

- nur relevante Codeabschnitte zurückgegeben werden

- Antworten strukturiert bleiben

Gerade bei Refactoring oder Bugfixes spart das enorm Tokens.

3. Hilfreiche Floskeln

Mini-Bausteine wie:

- „Nur geänderte Funktion zurückgeben“

- „Keine Erklärung, nur Code“

- „Max. 20 Zeilen“

- „Keine Einleitung“

Klingt banal – macht aber einen massiven Unterschied.

Für wen ist das gedacht?

Das Cheat Sheet richtet sich an Entwickler, die:

- regelmäßig mit Claude oder anderen LLMs arbeiten

- Token-Limits oder API-Kosten im Blick behalten

- reproduzierbare Ergebnisse statt Zufallsoutput möchten

- AI als Werkzeug nutzen – nicht als Plaudertasche

Gerade in größeren Projekten wird sauberes Kontext-Management zum echten Hebel.

Download

👉 Hier kannst du das Cheat Sheet als PDF herunterladen: Download